Chatbot für die Hosentasche

Raspberri Pi Zero mit Display und Powerbank

Mein Taschen-KI-Chatbot: Whisplay auf dem Raspberry Pi (und warum mich das Ding nicht mehr loslässt)

Ich wollte schon lange wissen, wie sich „AI“ anfühlt, wenn sie nicht als App im Handy wohnt, sondern als echtes Gerät: Einschalten, Knopf drücken, sprechen – und eine Stimme antwortet. Genau das habe ich mit dem Whisplay-AI-Chatbot umgesetzt: ein kleiner, tragbarer Sprach-Chatbot, der sich eher wie ein futuristisches Walkie-Talkie anfühlt als wie ein weiterer Bildschirm.

Die Idee: Stimme rein, Stimme raus – und zwar sofort

Das Grundprinzip ist herrlich direkt: Push-to-Talk drücken, Frage stellen, loslassen – und der Chatbot antwortet über den Lautsprecher. Kein Tippen, kein „Hey irgendwas“, kein Menü. Diese Einfachheit ist für mich der eigentliche Zauber: Es ist nicht „noch ein Chatfenster“, sondern eine kleine Interaktionsform, die man wirklich benutzt.

Hardware: klein, aber komplett

Ich habe den Chatbot auf einer sehr kompakten Kombi aufgebaut:

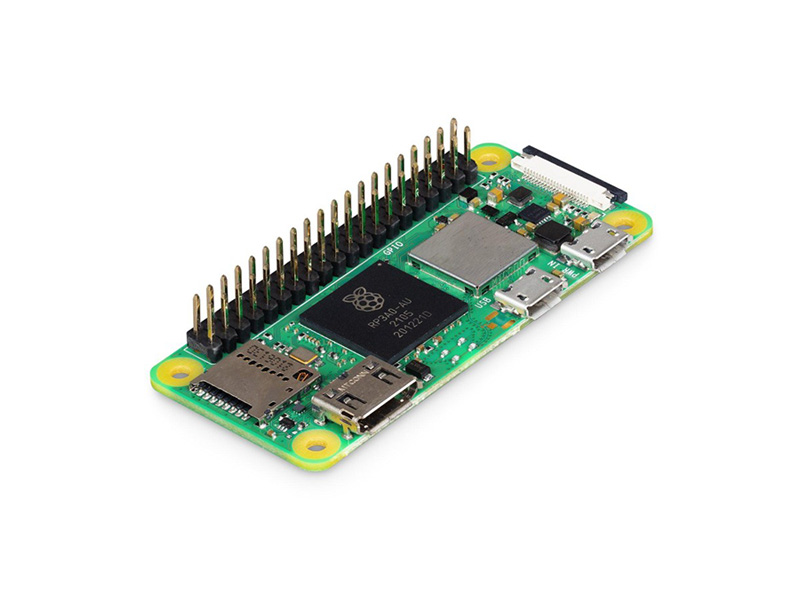

- Raspberry Pi Zero 2 W als Hauptrechner

- PiSugar Whisplay HAT als „Gesicht & Stimme“: kleines LCD, Mikrofon, Lautsprecher, Status-LEDs und ein Hardware-Button – alles auf einem Board, ohne Kabelsalat

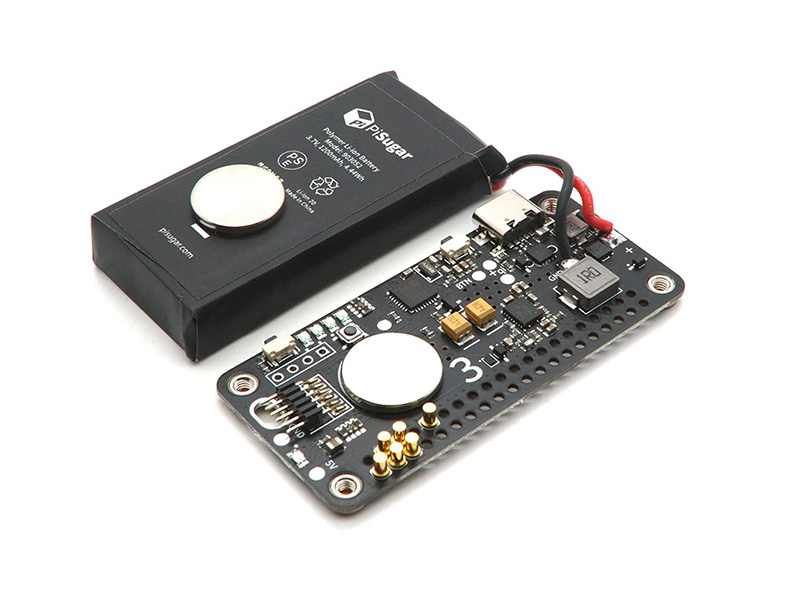

- PiSugar 3 (1200 mAh) als Akku/UPS, damit das Ganze wirklich „pocket-sized“ wird

- Dazu ein Gehäuse (bei mir 3D-gedruckt), damit es sich wie ein richtiges Produkt anfühlt und nicht wie ein Breadboard-Prototyp

Was ich daran liebe: Das Whisplay-HAT nimmt dir genau die Teile ab, die sonst jedes Bastelprojekt ausbremsen (Audio, Mic, Display, Button). Du steckst es auf, installierst den Treiber – fertig.

Software-Stack: pragmatisch und erstaunlich vielseitig

Unter der Haube läuft das Projekt als Service auf dem Pi. Die Logik ist so aufgebaut, dass sich das Ganze gut erweitern lässt

(z. B. eigene Tools/Skripte, die die KI auslösen darf). Praktisch fand ich auch, dass man vieles über eine .env-Konfiguration steuert

und das System auf Wunsch beim Boot automatisch startet – ideal, wenn man das Gerät „wie ein Gadget“ nutzen will und nicht wie einen Bastelrechner.

Ein paar Features, die ich im Alltag sofort gemerkt habe:

- Die KI kann die Lautstärke selbst anpassen (klingt banal, macht das Gerät aber deutlich „autonomer“).

- Wenn eine Weile niemand spricht, kann der Chatbot die Konversation automatisch zurücksetzen (hilft, damit das Ding nicht ewig im Kontext „hängen bleibt“).

- Gesprächsverlauf und generierte Bilder landen im data-Ordner – angenehm transparent.

Cloud oder komplett offline: ich habe beides ausprobiert

Das Projekt kann klassisch mit Cloud-APIs laufen (z. B. OpenAI/Gemini u. a.) – super für schnelle, starke Antworten auf kleiner Hardware. Richtig spannend wurde es für mich aber, als ich die Offline-Variante aufgebaut habe: Auf einem Raspberry Pi 5 (8 GB+) läuft der Chatbot vollständig lokal – mit Whisper für Speech-to-Text, Ollama für das lokale LLM und Piper für Text-to-Speech. Damit kann das Gerät ohne Internet „reden“, was nicht nur nerdig-cool ist, sondern auch ein ganz anderes Privacy-Gefühl gibt.

(Und ja: Auf dem Zero 2 W kann man zwar auch mit lokalen Modellen experimentieren, aber man merkt schnell die Grenzen – genau deshalb ist Pi 5 für „wirklich offline“ die entspanntere Wahl.)

Setup in der Praxis: angenehm „produktnah“

Ich habe es am Ende so eingerichtet, dass ich wirklich nur noch einschalte und losrede. Hilfreich dabei:

- Audio-/Display-Treiber für das Whisplay HAT installieren (ohne den geht’s natürlich nicht).

- Projekt bauen, starten und als Service laufen lassen (inkl. Logfile).

- Für einen schnellen Einstieg gibt es sogar vorkonfigurierte Images, die man direkt auf die SD-Karte flashen kann.

- Richtig praktisch unterwegs: WLAN-Konfig über BLE (per PiSugar-App/Wifi-Config), statt Tastatur/Monitor dranzuhängen.

Bonus: Bilder generieren – und direkt am Gerät sehen

Ein Feature, das bei mir sofort den „Wow“-Effekt ausgelöst hat: Bildgenerierung. Wenn man einen Image-Generation-Server in der Config aktiviert, kann man Prompts schicken und bekommt das Ergebnis direkt auf dem kleinen Display angezeigt; gespeichert wird es zusätzlich im Projektordner. Das ist natürlich Spielerei – aber genau die gute Sorte Spielerei, die zeigt, wie „multimodal“ so ein Mini-Gerät werden kann.

Warum mich das so fasziniert

Weil es drei Welten zusammenbringt, die sonst selten so sauber ineinandergreifen:

- KI wird greifbar. Nicht als Tab im Browser, sondern als Objekt mit Knopf, Screen und Stimme.

- Open Source + Bastelbarkeit. Ich kann es so anpassen, dass es zu meinem Alltag passt (Wortwahl, Stimme, Tools, Verhalten).

- Offline ist plötzlich realistisch. Auf dem Pi 5 fühlt sich „lokale KI“ nicht mehr wie ein Experiment an, sondern wie ein ernstzunehmender Modus – gerade für Situationen ohne Netz oder mit hohen Datenschutz-Ansprüchen.

Unterm Strich ist das für mich ein Projekt, das nicht nur „funktioniert“, sondern ein kleines Stück Zukunft in die Hand legt.